TL;DR : L'essentiel en 30 secondes

Si tu n'as pas le temps de tout lire, voici ce que tu dois absolument retenir sur le fonctionnement des Transformers (l'architecture derrière ChatGPT, Claude, Gemini...) :

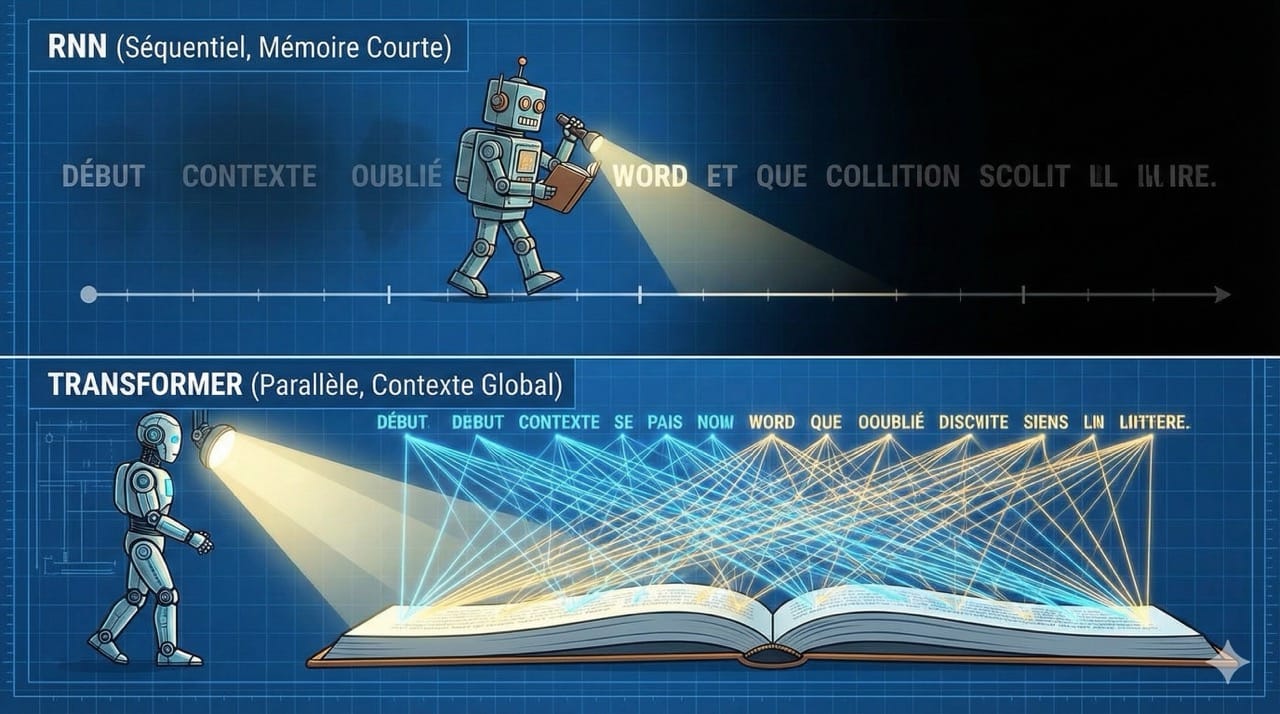

- Le problème des ancêtres (RNN) : avant 2017, les IA lisaient mot par mot (comme nous), ce qui les rendait lentes et amnésiques sur les phrases longues.

- La révolution Transformer : cette architecture lit toute la phrase d'un coup (parallélisation). Elle ne regarde pas l'ordre des mots, mais la relation entre tous les mots simultanément.

- Le secret est l'"Attention" : c'est le mécanisme qui permet à l'IA de comprendre le contexte. Dans "L'avocat est mûr", l'IA connecte mathématiquement "avocat" à "mûr" pour savoir qu'on parle du fruit, pas du métier de juriste.

- Implication Marketing #1 (Prompting) : prompter, c'est guider l'attention. Plus tu donnes de contexte précis (Rôle, Cible, Ton), plus tu aides le mécanisme d'attention à "allumer" les bons neurones et éteindre le bruit.

- Implication Marketing #2 (Hallucinations) : l'IA ne "sait" rien, elle prédit le prochain mot probable. C'est génial pour la créativité (associations inattendues) mais dangereux pour les faits (elle invente pour que la phrase sonne bien).

- Implication Marketing #3 (Few-Shot) : l'IA est une machine à compléter des motifs (patterns). Lui donner 3 exemples de ton style est plus efficace que de lui décrire ton style avec des adjectifs.

Dans un précédent article : “Quelle est la magie des IA derrière la génération des mots ?”, j’avais tenté d’expliquer la notion de tokenisation, essentielle au fonctionnement des IA.

Si tu l'as lu, tu sais maintenant que les Tokens sont les briques de Lego du langage et que les Embeddings (Vecteurs) sont leur carte d'identité sémantique. C'était la première étape.

Toutefois, avoir des briques et savoir ce qu'elles signifient individuellement ne suffit pas pour construire un édifice. Si je te donne les mots "Avocat", "Mûr", "Procès" et "Salade", ton cerveau fait immédiatement le tri grâce au contexte. Pour une IA, avant 2017, c'était un cauchemar.

Les anciens modèles lisaient mot par mot, oubliant le début de la phrase avant d’arriver à la fin. C’était ballot…

Puis est arrivé le “Transformer”.

C'est l'architecture qui a tout changé. C'est elle qui permet à ChatGPT de comprendre l'ironie, de coder, ou de rédiger une stratégie marketing cohérente.

Dans cet article, on va démonter le mécanisme d'attention pour comprendre comment la machine "réfléchit".

Je préfère te mettre en garde. Cet article est issu de mes recherches et des interprétations que je suis en mesure de faire. N’étant ni scientifique, ni spécialiste du domaine, il peut y avoir beaucoup d’imprécisions. Je m’en excuse par avance.

Mon objectif est principalement de donner une culture G sur le fonctionnement des IA afin que nous puissions mieux comprendre et donc mieux nous en servir.

Rapide rappel de la notion de tokenisation

Dans un LLM, chaque token est converti en un vecteur (appelé embedding). Ces vecteurs vivent dans un espace à plusieurs milliers de dimensions où les tokens qui ont des significations ou des contextes similaires sont regroupés ensemble.

Voici le processus que tu dois comprendre :

Le principe des embeddings (vecteurs de tokens)

Un être humain représente le mot "chat" par les lettres C-H-A-T (ou par un symbole).

Un grand modèle de langage représente chaque token (pas toujours un mot complet) par un vecteur de plusieurs centaines ou plusieurs milliers de nombres flottants. Par exemple :

chat → [0.0074, 0.0030, −0.0105, 0.0742, 0.0765, −0.0011, ..., 0.0002] (4096 dimensions ou plus selon le modèle)

Ce vecteur est appelé embedding.

Ces embeddings ne sont pas choisis au hasard : ils sont appris pendant l’entraînement du modèle. Résultat, tous les embeddings vivent dans un même espace vectoriel multidimensionnel (appelé espace sémantique) dans lequel :

- Les tokens ayant des significations ou des usages proches se retrouvent physiquement proches (distance cosinus ou euclidienne faible).

- Exemples concrets observés dans presque tous les modèles :

- "Chat", "chaton", "félin", "chien", "animal de compagnie" forment un groupe compact

- "Roi" est très proche de "reine", un peu plus loin de "prince" et "monarque"

- "Paris" (la ville) est proche de "France", "Eiffel", "Louvre"

- "Marcher", "courir", "sprinter", "trotter" forment un autre cluster

- "Bleu" est proche de "vert", "rouge", mais très loin de "démocratie" ou "additionner"

C'est cette organisation géométrique émergente qui permet au modèle de "comprendre" les relations sémantiques et de faire des opérations comme :

embedding("roi") − embedding("homme") + embedding("femme") ≈ embedding("reine")

L’entraînement massif crée “l’intelligence”

Les modèles les plus puissants de 2025 ont été entraînés sur des dizaines de milliers de milliards de tokens, soit 100 000 à 500 000 fois plus que tout ce qu’un enfant de 10 ans a lu ou entendu dans sa vie.

Pour donner des ordres de grandeur réalistes (2024-2025) :

- GPT-3 (2020) : ~300–500 milliards de tokens

- GPT-4 : estimations crédibles autour de 10–13 trillions de tokens

- Llama 3.1 405B, DeepSeek R1, Grok 3 : entre 15 et 30 trillions de tokens

- Certains modèles récents dépassent les 50–100 trillions

Sources de données utilisées (filtrées et dédoublonnées) :

- Une grande partie du web public (Common Crawl et dérivés raffinés)

- Des millions de livres numérisés

- L’intégralité de Wikipédia dans des centaines de langues

- Des dépôts de code (GitHub, etc.)

- Des articles scientifiques (arXiv, PubMed, Semantic Scholar…)

- Des sous-titres, transcriptions, forums, réseaux sociaux, etc.

Ce déluge de données, combiné à la représentation vectorielle des tokens, permet au modèle de détecter automatiquement des patterns et des analogies :

- S’il apprend que “Paris est à la France ce que Berlin est à l’Allemagne”, il applique immédiatement le même schéma à des centaines d’autres capitales.

- S'il sait tout sur les "chats", il transfère immédiatement une grande partie de ce savoir aux "chatons", "félins" ou "tigres" grâce à la proximité de leurs embeddings.

C’est cette généralisation par similarité dans l’espace sémantique, et non une simple mémorisation, qui constitue le cœur de l’”intelligence” des LLMs modernes.

Pourquoi les embeddings vectoriels seuls ne suffisent-ils pas à comprendre le langage ?

Les embeddings classiques (Word2Vec, GloVe, fastText) sont statiques : un même token possède toujours exactement le même vecteur, quel que soit le contexte.

Conséquences concrètes :

- Confusion sémantique : "banque" (de rivière) et "banque" (où on met de l'argent) ont exactement le même vecteur → le modèle ne peut pas savoir de laquelle on parle.

- Homonymes : "vol" (crime) et "vol" (action de voler dans les airs) → même vecteur. "bounce rate" en marketing email et en web analytics → même vecteur, donc même traitement.

- Ambiguïté non résolue : "I felt tokenized so I cashed in all my crypto". Avec des embeddings statiques, "tokenized" a un seul vecteur (souvent biaisé vers le sens NLP). Le modèle ne peut pas comprendre le jeu de mots ("traité comme un simple jeton" vs "transformé en tokens crypto").

- Puits sémantiques avec les anciens modèles (RNN/LSTM/GRU) : les modèles pré-2018 combinaient embeddings statiques + traitement séquentiel. Résultat : “Your website bounce rate is high. To reduce bounce rate, you should lower your bounce rate by monitoring bounce rate…” → le modèle s’enferme dans un “puits sémantique” parce qu’il n’a aucun moyen de savoir qu’il a déjà dit la même chose.

La révolution des Transformers : les embeddings deviennent contextuels

Depuis 2017 (BERT, GPT, T5, etc.), on ne parle plus d’embeddings statiques mais d’embeddings contextuels :

- Le token “banque” n’a plus un seul vecteur mais un vecteur différent à chaque occurrence, calculé dynamiquement par les couches d’attention en fonction de toute la phrase.

- Résultat :

- "Je vais à la banque déposer de l'argent" → vecteur proche de "compte", "guichet", "billet"

- "Il y a des poissons sous la banque de sable" → vecteur proche de "rivière", "sable", "courant"

C’est exactement cette capacité à produire des représentations différentes pour un même token selon son contexte qui a permis de passer d’une simple “compréhension statistique” à quelque chose qui ressemble vraiment à une compréhension du sens.

C’est le génie des mécanismes d’attention des Transformers.

Pourquoi les anciens modèles (RNN) ont échoué ?

Pour comprendre la puissance du Transformer, il faut regarder ce qu'on utilisait avant : les RNN (Réseaux de Neurones Récurrents).

Imagine que tu doives lire un livre entier à travers un trou dans une feuille de papier, mot après mot. Tu ne peux voir que le mot actuel et tu dois te souvenir de tous les précédents. C'était la vie d'un RNN.

Le problème majeur était la mémoire à court terme.

Si une phrase commençait par "La stratégie SEO..." et se terminait 50 mots plus loin par "... doit être priorisée", le modèle avait souvent oublié le sujet de la phrase en arrivant au verbe. Le contexte se diluait avec la distance.

De plus, ce traitement séquentiel (mot 1, puis mot 2, puis mot 3) rendait l'entraînement incroyablement lent. Impossible d'utiliser la puissance massive des GPU modernes qui adorent traiter des données en parallèle.

Le génie du Transformer : la parallélisation massive

En 2017, l'équipe de Google Brain publie "Attention Is All You Need". L'idée est radicale : arrêter de lire séquentiellement.

Le Transformer ne lit pas la phrase de gauche à droite. Il lit toute la phrase d'un coup.

Il ingère l'ensemble des tokens simultanément. Cela offre deux avantages critiques :

- Vitesse : on peut entraîner le modèle sur des milliards de pages web en parallèle (ce qui a permis la naissance de GPT).

- Contexte global : le modèle voit la fin de la phrase en même temps que le début. Il sait que "l'avocat" est un fruit car il voit le mot "salade" apparaître plus loin dans la séquence instantanément.

L'article "Attention Is All You Need" (Vaswani et al., Google, juin 2017) introduit deux révolutions simultanées :

- Parallélisation totale : comme nous venons de le voir, les anciens modèles (RNN, LSTM, GRU) étaient obligés de traiter les tokens un par un, dans l’ordre, exactement comme on lit un livre. Le Transformer, grâce au mécanisme de self-attention, calcule les relations entre tous les tokens en même temps. Conséquences pratiques :

- Temps d’entraînement divisé par 10 à 100 selon la taille

- Possibilité d’entraîner sur des centaines de GPU/TPU en parallèle → c’est cette parallélisation qui a rendu possibles les modèles de plusieurs centaines de milliards de paramètres (GPT-3, PaLM, Llama 3, Grok, etc.).

- Contexte vraiment global et instantané : dans un RNN, quand on traite le mot “avocat” au milieu d’une phrase, le modèle n’a vu que les mots précédents.

Dans un Transformer :- Pendant l’entraînement et l’inférence des modèles encodeurs (BERT, RoBERTa…), chaque token voit toute la phrase complète dès le début (contexte bidirectionnel).

- Dans les modèles décodeurs-only (GPT, Llama, Grok, Mistral…) → chaque token ne voit que les tokens précédents (contexte causal), mais l’attention est calculée en parallèle sur toute la séquence déjà générée, ce qui offre beaucoup plus de contexte.

L’encodage positionnel : injecter une notion d’ordre dans le parallèle

Les Transformers traitent tous les tokens en parallèle, comme un sac de mots en vrac ("Le", "chat", "mange"), sans notion innée d'ordre séquentiel. Comment distinguent-ils alors "Le chat mange" de "Mange le chat", ce qui change bien évidemment le sens ?

C’est l’encodage positionnel (positional encoding) qui résout ça : on ajoute à chaque embedding de token un vecteur spécifique à sa position dans la séquence.

Exemple simplifié :

- Token "Le" (position 1) : embedding("Le") + PE(1)

- Token "chat" (position 2) : embedding("chat") + PE(2)

- Token "mange" (position 3) : embedding("mange") + PE(3)

Où PE(pos) est un vecteur calculé avec des sinus et cosinus (ex. : PE(pos, 2i) = sin(pos / 10000^{2i/d}) pour les composantes paires), de même dimension que l’embedding.

Résultat : le modèle conserve le sens sémantique (via l’embedding) tout en encodant les relations positionnelles (absolues et relatives). Les couches d’attention peuvent ainsi “voir” que le sujet précède le verbe, même dans des phrases longues.

Le cœur du réacteur : le mécanisme d'Attention (Self-Attention)

C'est la partie la plus importante. C'est ce qui fait que l'IA semble "intelligente".

Le mécanisme de Self-Attention permet au modèle de peser l'importance de chaque mot par rapport aux autres dans une même phrase.

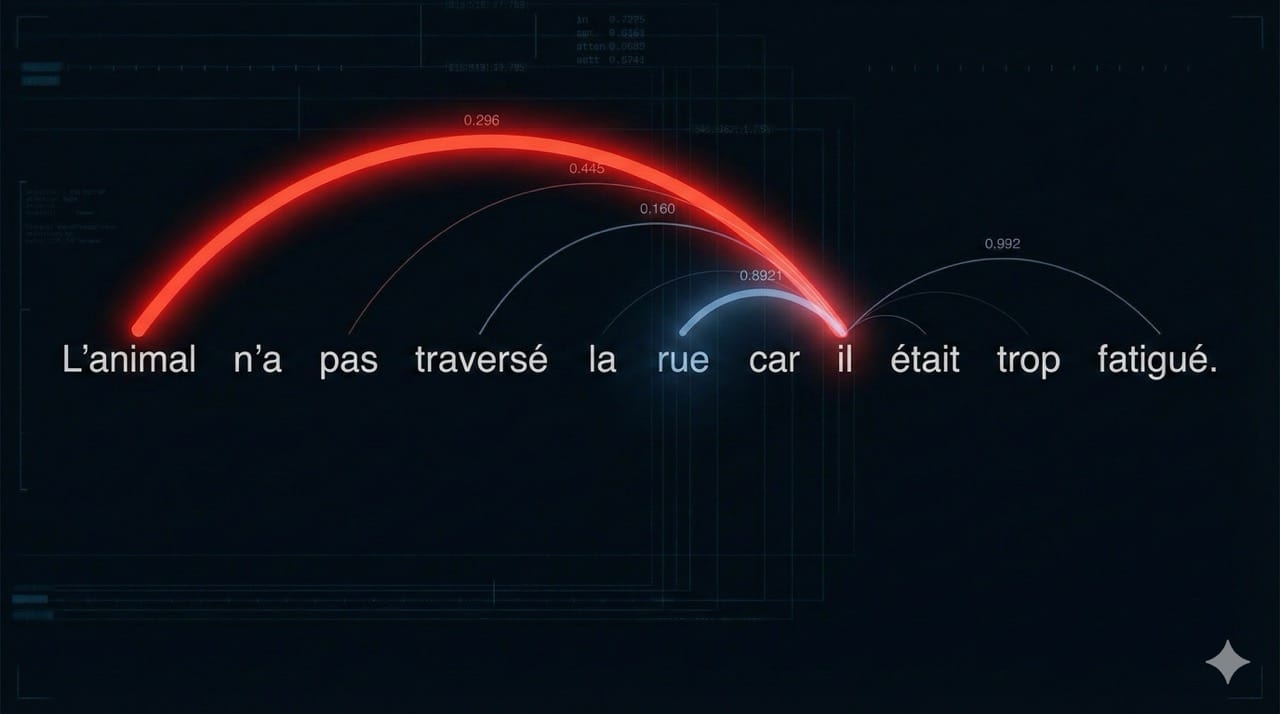

Prenons cette phrase ambiguë :

"L'animal n'a pas traversé la rue car il était trop fatigué."

Pour nous, "il" désigne l'animal.

Si la phrase était :

"L'animal n'a pas traversé la rue car elle était trop large."

Ici, "elle" désigne la rue.

L'ancien système (vecteurs statiques) voyait le mot "il" ou "elle" de façon isolée. Le Transformer, grâce à l'Attention, crée des liens invisibles entre les mots.

Quand il traite le mot "il", son mécanisme d'attention "s'allume" fortement sur le mot "animal" et faiblement sur le mot "rue". Il comprend la relation de cause à effet grammaticale et sémantique.

"L'Attention" permet ainsi au modèle de focaliser ses ressources sur les mots pertinents pour un contexte donné et d'ignorer le bruit. C'est une compréhension dynamique du sens.

L’analogie Query / Key / Value expliquée simplement

Le mécanisme d’attention repose sur trois concepts simples : Query (Q), Key (K), et Value (V).

Imagine que tu cherches un livre dans une immense bibliothèque, tout se passe en parallèle, comme si des milliers de bibliothécaires travaillaient simultanément.

- Query (la requête) : c’est ce que tu cherches activement. Par exemple, un post-it avec “Nutrition pour sportifs”. C’est l’intention actuelle d’un token.

- Key (la Clé) : c'est le titre sur la tranche de chaque livre. Tu compares ta Query avec chaque Key ("Histoire de France", "Recettes Véganes", "Diététique du coureur") pour calculer un score de similarité.

- Value (la Valeur) : c’est le contenu réel du livre. Une fois les scores calculés (hauts pour les matches pertinents), tu fais une somme pondérée des Values : plus le score est élevé, plus tu “absorbes” d’information de ce livre.

Dans un Transformer, pour chaque couche d’attention :

- Tous les tokens projettent leurs embeddings en Q, K, V simultanément.

- Chaque Q compare avec tous les K (y compris le sien) pour des scores d’attention.

- Exemple : dans "L'animal fatigué miaulait. Il avait faim."

- "Il" (Query) scanne les Keys : score faible avec "miaulait" ou "faim", score élevé avec "animal".

- "Il" absorbe alors le Value de "animal" (enrichi par "fatigué"), devenant un vecteur qui encode mathématiquement "animal fatigué".

C’est cette pondération dynamique qui permet au modèle de contextualiser chaque token avec l’ensemble de la séquence, en parallèle et efficacement.

Bon, je ne sais pas si c’est une explication simple en fait. 😅

De la probabilité à la réponse finale : comment naît la "créativité"

Une fois que l'information a traversé ces couches d'attention (souvent des dizaines de fois dans des modèles comme Gemini), le modèle arrive à une étape finale : la prédiction.

Le Transformer ne "sait" rien. Il calcule des probabilités.

À la fin du traitement, il produit une liste de tous les mots de son vocabulaire avec un score de probabilité pour être le prochain mot.

Si tu écris "Le ciel est...", le modèle a calculé, grâce à l'attention, que le contexte est météorologique et visuel.

- Bleu : 75%

- Gris : 20%

- Dégagé : 4%

- Banane : 0.0001%

C'est là qu'intervient la température.

- Température 0 : déterministe et greedy : l'IA choisit toujours le token au score le plus élevé ("bleu"). Résultat : réponses factuelles, prévisibles, robotiques.

- Température 1 (défaut dans beaucoup de modèles) : sampling proportionnel aux probs réelles. L'IA peut choisir "gris" (20% de chance) ou "dégagé" (4%). C'est là que naissent la variabilité et la "créativité" perçue.

- Température >1 : plus aléatoire, amplifie les outsiders (pour de la génération créative extrême).

- Température <1 : Plus conservateur, rend les pics encore plus pointus (pour de la précision).

En pratique, on combine souvent avec top-p (nucleus sampling : ignorer les tokens improbables cumulés au-delà d’un seuil, ex. 0.95) ou top-k (seulement les k plus probables) pour éviter les délires inutiles.

Si tu es arrivé jusqu'ici, bravo 👏🤩😅

Tu auras compris que le Transformer n'est pas magique. C'est une merveille d'ingénierie statistique qui a résolu le problème de la mémoire et du contexte.

Là où les vecteurs donnaient un sens aux mots isolés, le Transformer donne un sens aux relations entre les mots. L’IA aurait dit : “Il transforme une liste d’ingrédients bruts en une recette complexe et structurée”. 🤒

Comprendre cela te permet de mieux prompter : quand tu donnes du contexte à ChatGPT, tu fournis en réalité de meilleures "Keys" à son mécanisme d'attention, lui permettant de récupérer les "Values" les plus pertinentes de son immense base de connaissances.

Et maintenant ?

Tu as compris les Tokens, les Vecteurs et l'Architecture. La prochaine étape logique est de comprendre comment on entraîne ces monstres. Je t'expliquerai le "pre-training" vs le "fine-tuning" dans un prochain article !

Mais avant cela, voici les implications concrètes de ce que tu viens de lire sur ton marketing.

Ce que l'architecture Transformer change concrètement pour ton marketing

Tu te demandes peut-être : "Pourquoi ai-je besoin de comprendre les mécanismes d'Attention et de vecteurs pour écrire une newsletter ou une page de vente ?"

Parce que comprendre l'outil est la seule façon de passer du stade "utilisateur qui bidouille" à "Expert". Une fois que tu as compris que le Transformer est une machine statistique de prédiction de contexte, voici les 4 lois immuables pour ton marketing :

1. Le Prompting n'est pas de la magie, c'est de la "Gestion d'Attention"

Rappelle-toi l'analogie de la bibliothèque (Query / Key / Value). Quand tu rédiges un prompt générique type "Écris un article sur le SEO", tu donnes une Query floue. L'IA va “scanner sa base de connaissances” et s'activer sur des Keys génériques (SEO technique ? Backlinks ? Contenu ?). Résultat : tu obtiens du contenu "moyen", du slop…

L'implication marketing : pour obtenir de la qualité, tu dois forcer le mécanisme d'Attention du modèle à se focaliser sur les bons vecteurs.

- Mauvais : "Agis comme un expert marketing."

- Bon : "Tu es un expert en Growth B2B pour les SaaS. Ton audience est composée de CTOs sceptiques. Ton ton doit être data-driven, sans adjectifs superflus."

En faisant cela, tu restreins l'espace vectoriel dans lequel le modèle cherche ses mots. Tu élimines les Keys "marketing grand public" pour ne garder que les Keys "B2B technique".

2. L'hallucination est une "feature", pas un bug

Le Transformer ne stocke pas de faits (comme une base de données SQL). Il stocke des probabilités de relations entre les mots. Quand il invente une fausse citation ou une statistique erronée, il ne "ment" pas. Il prédit simplement une suite de mots qui est statistiquement plaisante et cohérente avec la structure d'une phrase factuelle.

L'implication marketing :

- Pour la création (copywriting, idéation) : c'est une force. Le modèle peut associer des concepts éloignés (ex: "Explique le marketing avec une analogie de Star Wars") car il trouve des chemins vectoriels inédits. Utilise une température élevée (0.7 - 1).

- Pour la recherche (fact-checking) : c'est dangereux. Ne demande jamais à un LLM brut de te donner des sources ou des chiffres précis sans vérifier. Il privilégiera toujours la forme (la phrase sonne bien) sur le fond (la phrase est vraie).

3. Le "Few-Shot Prompting" exploite la capacité de suite logique

Le Transformer lit toute la séquence d'un coup. Il est conçu pour repérer des patterns (motifs) et les reproduire. C'est sa fonction première : compléter la suite logique.

L'implication marketing : si tu veux que l'IA écrive avec TA voix et TON style, ne lui décris pas ton style ("sois drôle et incisif"). Montre-le-lui. Donne-lui 3 exemples de tes meilleurs posts LinkedIn (Input), suivis de la consigne "Écris le 4ème sur ce sujet". Le mécanisme d'Attention va analyser les vecteurs de tes exemples (vocabulaire, longueur des phrases, structure) et appliquera mathématiquement ce même pattern au nouveau contenu. C'est bien plus puissant que n'importe quelle description adjectivale.

4. La fenêtre de contexte est ta mémoire vive

Nous avons vu que l'Attention a un coût de calcul. C'est pourquoi les modèles ont une limite de tokens (la fenêtre de contexte).

L'implication marketing : si tu donnes un PDF de 100 pages à ChatGPT et que tu poses une question sur un détail de la page 45, il est possible qu'il "l'oublie" ou hallucine. C'est le phénomène de "Lost in the Middle".

Pour tes analyses de marché ou tes résumés de réunions :

- Segmente tes données.

- Assure-toi que les informations critiques (l'objectif du prompt) sont répétées à la fin du prompt, car les Transformers accordent souvent plus de poids ("Attention") aux éléments les plus récents de la séquence.

Astuce Pro : considère le LLM comme un stagiaire surdoué mais amnésique et menteur par complaisance. Si tu lui donnes le bon contexte (les bons documents), des instructions claires (le bon framework) et des exemples (le bon pattern), il surpassera bien des humains. Si tu le laisses deviner, il racontera n'importe quoi avec une assurance totale.

FAQ : Questions Fréquemment Posées sur les Transformers

1. Quelle est la différence entre BERT et GPT ?

Tous deux sont des Transformers. BERT (Bidirectional) utilise l'encodeur pour comprendre le texte (idéal pour la classification). GPT (Generative Pre-trained Transformer) utilise le décodeur pour générer du texte mot après mot (idéal pour la rédaction).

2. Pourquoi parle-t-on de "fenêtre de contexte" ?

C'est la limite de la mémoire vive du Transformer. Puisqu'il doit calculer l'attention de chaque mot par rapport à tous les autres, la complexité calculatoire explose avec la longueur du texte. C'est pourquoi GPT-4 a une limite de tokens (ex: 32k ou 128k).

3. Le Transformer comprend-il vraiment ce qu'il dit ?

Non. Il manipule des symboles mathématiques. Il ne connaît pas le concept physique d'une "pomme", il connaît uniquement les relations statistiques entre le mot "pomme", "fruit", "rouge" et "manger". C'est de la corrélation, pas de la compréhension cognitive.

4. Est-ce que l'IA apprend de mes conversations en temps réel ?

Non, et c’est une confusion fréquente. Le modèle est "gelé" après son entraînement. Quand tu parles avec ChatGPT, il ne met pas à jour ses connexions neuronales (ses poids). Il utilise sa "fenêtre de contexte" (mémoire vive) pour retenir ce que tu as dit il y a 5 minutes, mais dès que tu fermes la session, cette information disparaît. Il n'apprend pas de toi, il s'adapte à toi temporairement.

5. Comment empêcher totalement les hallucinations ?

C'est impossible par design (car le modèle est probabiliste), mais on peut les réduire drastiquement via une technique appelée RAG (Retrieval-Augmented Generation). Au lieu de laisser l'IA puiser dans ses souvenirs flous, on lui fournit des documents de référence (PDF, URL) dans le prompt et on lui ordonne de répondre uniquement en utilisant ces sources. C'est la différence entre passer un examen de mémoire (risque d'erreur) et un examen à livre ouvert (fiabilité accrue).

6. Les IA qui analysent les images (GPT-4o, Midjourney) sont-elles aussi des Transformers ?

Absolument. C'est la force de cette architecture : elle est "modale-agnostique". Une image est découpée en petits carrés (patches), chaque carré est converti en vecteur, et le Transformer traite ces carrés exactement comme des mots. Pour l'architecture, qu'il s'agisse d'un pixel, d'une onde sonore ou d'un mot, c'est juste un token mathématique à placer dans un contexte.